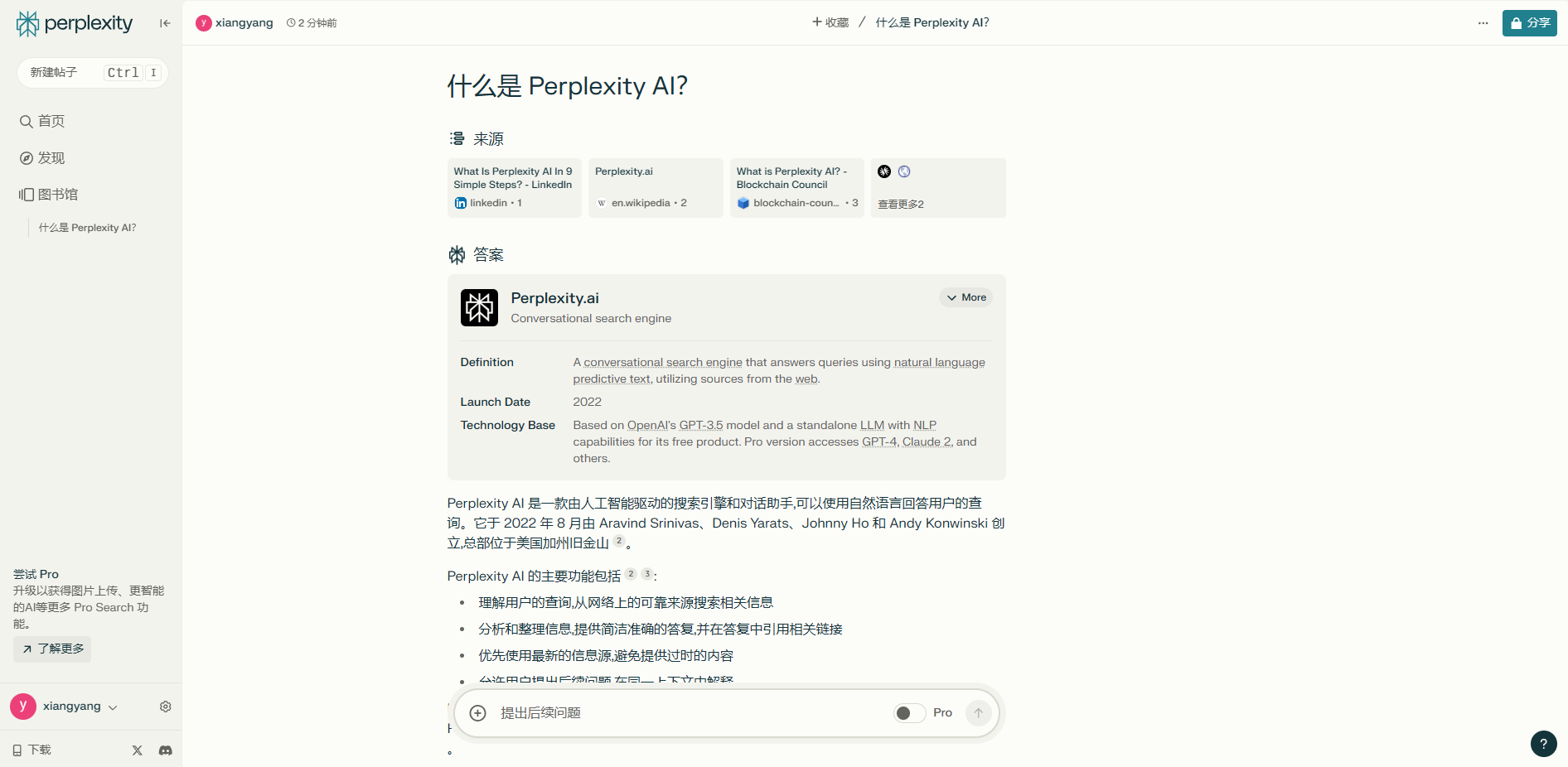

全面开源!DeepSeek R1 671B 官方版发布,支持本地+云端部署,绕过硬件限制

全面开源!DeepSeek R1 671B 官方版发布,支持本地+云端部署,绕过硬件限制

時光前言

DeepSeek-R1 虽然有1.5b、7b、8b、14b、32b等,但是这些都是量化版,非满血版,真正和官方一样的满血版只有一个,那就是未量化的 671b DeepSeek-R1 大模型!是目前最强最聪明的一个开源模型。

本地部署的最低硬件要求:

1 | CPU:32核Intel Xeon或AMD EPYC |

部署步骤

1、安装 Ollama

Ollama下载2、下载并部署 671b Deepseek R1 模型:

1 | ollama run deepseek-r1:671b |

3、UI 调用模型

点击安装如何卸载已安装过的模型?

2

ollama rm 模型名称 # 卸载并删除模型

4、土豪套餐 【云端部署】

在云端部署真正满血版的671b Deepseek R1 模型,需要你钱包够硬,在线开通高级的云GPU

在线开通专业级云GPU别盲目跟从,价格都是按小时计费的,不便宜,当然土豪们可以无视!

云端部署 deepseek-r1-671b 命令:

1 | curl -fsSL https://ollama.com/install.sh | sh |

然后通过Open-WebUI 来调用deepseek-r1-671b 模型,安装命令如下:

1 | docker run -d -p 8082:8080 -v open-webui:/app/backend/data --name Open-WebUI --restart always ghcr.io/open-webui/open-webui:main |

然后访问 http:// 服务器IP:8082,打开后在 Open-WebUI “Models” 设置中,添加 deepseek-r1,即可使用!

如果服务器有防火墙,记得开放 8082端口,否则外网无法访问

参考

评论

匿名评论隐私政策

✅ 你无需删除空行,直接评论以获取最佳展示效果